¿Cómo debería comportarse un coche autónomo ante un accidente inevitable?

El MIT enfrenta a dos millones de personas a un juego de ética que tendrán que resolver los vehículos sin conductor en el futuro

Madrid

El pasado mes de marzo, una mujer fallecía en Tampa (Arizona) después de ser golpeada por un coche sin conductor mientras cruzaba la calle de noche. Un atropello, el primero con consecuencias mortales por parte un coche sin conductor de Uber, que obligó a la compañía a suspender todas las pruebas relacionadas con este tipo de vehículos y que abrió un nuevo debate en torno a este tipo de vehículos.

Más información

Sin embargo, el debate en torno a los problemas éticos que tendrán que resolver los vehículos sin conductor viene de atrás. Con el objetivo de establecer las bases sobre las decisiones que deberán tomar los vehículos autónomos cuando se enfrenten a decisiones de vida o muerte, un grupo de investigadores del MIT Media Lab desarrollaban el programa 'Moral Machine' en 2016.

Tres respuestas universales y un mar de dudas

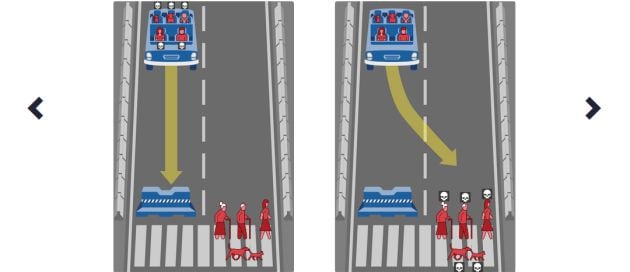

Una plataforma, creada para recopilar una perspectiva humana sobre las decisiones morales tomadas por las máquinas inteligentes, mediante la que los investigadores mostraban una serie de dilemas morales a los diferentes usuarios donde un coche sin conductor debe elegir el menor de dos males en un paso de peatones.

Después de observar el comportamiento de más de dos millones de usuarios, y obtener cerca de 40 millones de respuestas, los investigadores han publicado los resultados del estudio en un artículo publicado en la revista de divulgación científica Nature. Una publicación que determina que los coches autónomos deberían primar la vida de grupos numerosos por delante de otros con menos personas, que tendrían que salvar la vida de los humanos por encima de la de los animales y que preserven la seguridad de los jóvenes en lugar de las personas mayores, tal y como explica el principal autor del estudio, Edmond Awad, en el blog del MIT.

Uno de los ejemplos de la encuesta. / Moral Machine

Uno de los ejemplos de la encuesta. / Moral Machine

Sin embargo, el resto de respuestas demuestran que existen diferencias en base a la nacionalidad del usuario. De hecho, los investigadores descubrieron un patrón de preferencias morales dependiendo de si se trataba de países catalogados 'del oeste', 'del este' o 'del sur'. Mientras que los encuestados de los estados del sur primaban la vida de los jóvenes en lugar de los ancianos en mayor medida que la media, los del este mostraban una mayor preferencia por preservar la vida de los ancianos. Por esa misma razón, los analistas consideran que sería complicado desarrollar una ley universal para estos vehículos.

Las preguntas más complicadas

A pesar de que estas tres preguntas fueron resueltas por la gran mayoría de usuarios de la misma forma, hubo otros escenarios en los que los usuarios no lo tuvieron tan claro. Cada vez que los dilemas se volvían más complejos, los resultados se dividían. En uno de los ejemplos expuestos por el grupo de investigadores durante el Foro Global de Educación y Habilidades en Dubai, celebrado el pasado mes de abril, los expertos aseguraron que en la disyuntiva entre atropellar a una persona cruzando la carretera de forma completamente legal y atropellar a dos personas que lo hacen de forma ilegal, las respuestas se dividían al 50%.

¿Y si un vehículo no puede frenar a tiempo ante un paso de peatones transitado? Según recoge el estudio, los encuestados determinan que el coche autónomo debería salvar en primer lugar la vida de un bebé a bordo de un carrito, seguido de otros peatones como una niña, un niño y una mujer embarazada. Por otro lado, los peatones más sacrificables serían los sintecho. Tras ellos se encuentran otros como los ancianos, los delincuentes y las mascotas. Sin embargo, una vez más, las preferencias cambian dependiendo de la región desde la que se hace la encuesta.

Lo mismo sucedía cuando estaba en juego la vida del participante. Según relatan los investigadores, hasta un 40% de los participantes declararon que daba a igual a quién hubiera que matar siempre y cuando pudieran preservar su vida. En definitiva, los autores del estudio determinan que sería prácticamente imposible desarrollar una ley universal.

David Justo

(Astrabudua, 1991) Periodista especializado en tecnología que aborda la vida digital desde otro punto...